- C’est quoi le web scraping et le data scraping ?

- Quels sont les avantages du web scraping et du data scraping ?

- Quels sont les défis du web scraping ?

- Comment réussir un web scraping efficace sans coder ?

- Quelles sont les données qu’on peut scraper ?

- On se fait un récap sur le web scraping et le data scraping

- Foire aux questions

Le web scraping et le data scraping, ça vous dit quelque chose ? 🤔 Si vous avez déjà entendu parler de ces termes, mais que vous ne savez pas vraiment ce qu’ils impliquent, vous êtes au bon endroit ! 🌐 Ces techniques permettent d’extraire des données précieuses sur internet, comme un détective numérique à la recherche d’infos cachées. 🕵️♂️

Dans cet article, on va vous expliquer simplement ce que c’est et vous montrer 5 outils géniaux pour mettre en place. Prêt à plonger dans l’univers du scraping ? Let’s go !

C’est quoi le web scraping et le data scraping ?

Avant de plonger dans les applications concrètes, commençons par poser les bases : que signifient exactement le web scraping et le data scraping ? Ces deux techniques sont souvent confondues, mais elles ont des particularités qui méritent d’être clarifiées.👀

Le web scraping, c’est un peu comme envoyer un assistant virtuel fouiller sur internet pour récupérer des informations spécifiques.✨ Par exemple, imaginons que vous gériez une boutique en ligne et que vous vouliez suivre les prix de vos concurrents. Le web scraping va automatiser ce travail en collectant directement les données des sites web concernés.

En pratique, il s’agit d’un processus qui extrait et structure les informations visibles sur le web, comme des listes de produits, des avis clients, des horaires, ou même des publications. 🔢

`De son côté, le data scraping, parfois appelé « scraping de données », est un concept plus large. Cette technique ne se limite pas à l’extraction de données sur Internet. Elle englobe aussi la collecte d’informations depuis d’autres sources numériques, comme des fichiers locaux (CSV, Excel) ou des bases de données. 📊

Là où le web scraping se concentre sur le web, le data scraping vise toutes les données numériques accessibles, quelle que soit leur origine.

Ces deux méthodes sont devenues indispensables dans de nombreux domaines, que ce soit pour analyser des tendances, optimiser des processus métier, ou automatiser des tâches répétitives. Et la meilleure partie ? Elles permettent de gagner un temps fou et de travailler de manière beaucoup plus efficace. 🚀

Quels sont les avantages du web scraping et du data scraping ?

Le web scraping et le data scraping ne sont pas seulement des techniques tendances, mais de véritables atouts pour améliorer votre efficacité et gagner du temps. Si vous hésitez encore à vous y mettre, voici pourquoi ces méthodes sont indispensables pour de nombreux professionnels aujourd’hui.🤩

1. Veille concurrentielle au top

Dans un monde où la compétition est de plus en plus féroce, connaître les actions de vos concurrents en temps réel peut faire toute la différence. Grâce au web scraping, vous pouvez automatiser la collecte d’informations provenant de leurs sites web :

- Leurs stratégies marketing. 😎

- Leurs nouveaux produits.🛍️

- Leurs prix.💸

- Leurs promotions.♻️

Cela vous permet de réagir rapidement aux changements du marché et d’ajuster vos propres actions pour rester compétitif. La veille concurrentielle devient ainsi un jeu d’enfant, à portée de clic. 📊

2. Analyse de marché simplifiée

Avoir une vision claire et complète de votre marché est essentielle pour prendre des décisions éclairées. Le web scraping vous permet de collecter des données provenant de multiples sources en ligne : forums, blogs, réseaux sociaux, sites spécialisés… Vous pouvez ainsi analyser les tendances du secteur, repérer les besoins émergents des consommateurs et même suivre les avis clients. 🛍️

Plutôt que de passer des heures à rassembler des informations, vous pouvez maintenant obtenir des rapports détaillés en un temps record. Cela vous aide à mieux comprendre votre audience et à ajuster votre offre en conséquence.🤓

3. Automatisation des tâches répétitives

Le scraping vous aide à automatiser des tâches difficiles et répétitives, comme la collecte d’informations sur différents sites, la création de fichiers de prospection ou la mise à jour de bases de données. 🕒

Plutôt que de passer des heures à récupérer manuellement des données, vous pouvez laisser un outil de scraping faire le travail à votre place, de manière continue et sans erreurs. 😇

Cela vous libère du temps pour vous concentrer sur des tâches à plus forte valeur ajoutée, tout en garantissant une extraction de données précise et cohérente. Un gain de productivité incroyable !

4. Des solutions économiques

Le scraping est un moyen économique et accessible pour collecter des bases de données, même pour les petites entreprises ou les indépendants. De nombreux outils de scraping sont gratuits ou proposent des versions abordables. 💰

Plutôt que de faire appel à des consultants ou à des services externes coûteux pour obtenir des informations sur le marché, vous pouvez utiliser des solutions de scraping pour récolter ces données vous-même. Vous bénéficiez de données en temps réel sans devoir dépasser votre budget. 💰

5. Sécurité des données

L’un des points souvent abordés dans le domaine du scraping est la question de la sécurité et de la légalité. En utilisant des outils de scraping respectueux des normes et des bonnes pratiques, vous pouvez collecter des données publiques sans compromettre la sécurité de vos informations. 🔒

De plus, certaines solutions de scraping intègrent des technologies avancées pour garantir la confidentialité et la protection des données extraites, comme Waalaxy ou Phantom Buster. En choisissant les bons outils, vous assurez non seulement la conformité de votre démarche, mais aussi la sécurité des données collectées.😎

Quels sont les défis du web scraping ?

Le web scraping et le data scraping, c’est super pratique, mais ce n’est pas toujours un long fleuve tranquille. Ces techniques viennent avec leur lot de défis qu’il vaut mieux connaître avant de se lancer. Voici les principales embûches et comment les surmonter.🥹

1. Les défis techniques

Mettons les choses au clair : le scraping n’est pas toujours un jeu d’enfant. 🛠️ Les sites web évoluent constamment, avec des designs complexes, des structures dynamiques (merci JavaScript 😅), et parfois des protections anti-scraping. Vous devrez peut-être jongler avec des outils spécifiques ou même développer des solutions sur mesure pour contourner ces obstacles techniques. Heureusement, il existe de nombreux frameworks et outils no-code (comme Waalaxy) pour vous simplifier la vie ! 🙌🏻

2. Le cadre légal

Le web scraping soulève souvent des questions juridiques, et il est essentiel de respecter le cadre légal. Même si vous collectez des données publiques, cela ne veut pas dire que vous pouvez les utiliser comme bon vous semble. ⚖️

Certains sites interdisent explicitement le scraping dans leurs conditions générales d’utilisation. Avant de commencer, mieux vaut vérifier si vous êtes en conformité pour éviter de potentiels problèmes. Conseil : restez sur des données accessibles publiquement (RGPD) et utilisez-les à des fins éthiques !👀

3. Les sites protégés

Certains sites ne sont pas très fans du scraping, et ils mettent en place des protections pour empêcher l’extraction de leurs données. 🛡️ Captcha, restrictions IP, ou encore systèmes de détection avancés : voilà quelques exemples de barrières que vous pourriez rencontrer. 😥

Pour contourner ces obstacles, il existe des solutions comme l’utilisation de proxies ou de services spécialisés. Mais, attention : ne pas trop insister sur les sites protégés, car cela peut être perçu comme une atteinte à leurs règles.😥

Un proxy, c’est comme un intermédiaire entre vous et Internet : il masque votre adresse IP pour garder votre navigation privée. 🌐 Super utile pour contourner les restrictions, protéger vos données ou même scraper des sites sans vous faire bloquer ! 🚀

Comment réussir un web scraping efficace sans coder ?

Vous pensez que le web scraping est réservé aux experts en programmation ? Bonne nouvelle : ce n’est pas le cas ! Avec les outils no-code, tout le monde peut s’y mettre, même sans une ligne de code. 👩🏻💻

Pourquoi opter pour le no-code ?

Les solutions no-code sont idéales pour se lancer rapidement dans le web scraping, même si vous n’avez aucune compétence technique. 🎯 Voici leurs principaux avantages :

- C’est plus simple : Pas besoin de maîtriser HTML, Python ou JavaScript, tout se fait via des interfaces intuitives.😍

- C’est rapide : En quelques clics, vous configurez vos extractions et obtenez vos données.📊

- C’est accessible à toute votre équipe : Pas besoin d’un développeur dédié. Les marketeurs, analystes ou responsables produits peuvent facilement s’en servir.👭

➡️ Voici quelques conseils pour un scraping réussi :

- Identifiez des sources fiables et accessibles.

Avant de commencer, listez les sites ou les plateformes où trouver les données dont vous avez besoin. 🌐 Optez pour des sources fiables qui permettent un accès libre aux informations publiques pour éviter tout problème légal ou technique, par exemple, LinkedIn.✨ - Comprenez les formats de sortie.

Lorsque vous scrapez des données, vous pouvez les exporter sous différents formats comme CSV, JSON ou Excel. 📁 Avant de commencer, réfléchissez à celui qui correspond le mieux à vos besoins. Par exemple, le CSV est parfait pour des analyses dans Excel, tandis que JSON est idéal pour des outils plus techniques comme un CRM. - Familiarisez-vous avec les limitations techniques.

Même en no-code, il est important de connaître les défis techniques :- Les Captchas (ces fameux tests « Je ne suis pas un robot ») peuvent bloquer vos tentatives.🤖

- Les blocages d’adresse IP peuvent survenir si vous scrapez trop rapidement.🚫

- Certains sites sont tout simplement protégés contre le scraping.🛡️

Quelles sont les données qu’on peut scraper ?

Le web est une vraie mine d’or ! Avec le web scraping, vous pouvez extraire plein de types de données, mais attention : tout ce qui est techniquement faisable n’est pas forcément légal. Voici un aperçu des données que vous pouvez scraper (dans les règles, bien sûr !). 🚀

1. Les données structurées

Ce sont les données bien organisées et super faciles à extraire, comme :

- Tableaux de prix : Vous voulez surveiller les prix de vos concurrents ? Scraper leurs offres peut vous aider à ajuster les vôtres et à rester compétitif. 🛒

- Avis clients : Les retours des utilisateurs sur des produits ou services sont précieux pour analyser les tendances marketing, identifier les points d’amélioration et anticiper les attentes des consommateurs. ⭐

- Listings et annuaires : Récupérez des informations sur des entreprises, des événements, ou des produits depuis des répertoires publics, idéal pour enrichir vos bases de données ou préparer des campagnes ciblées. 📋

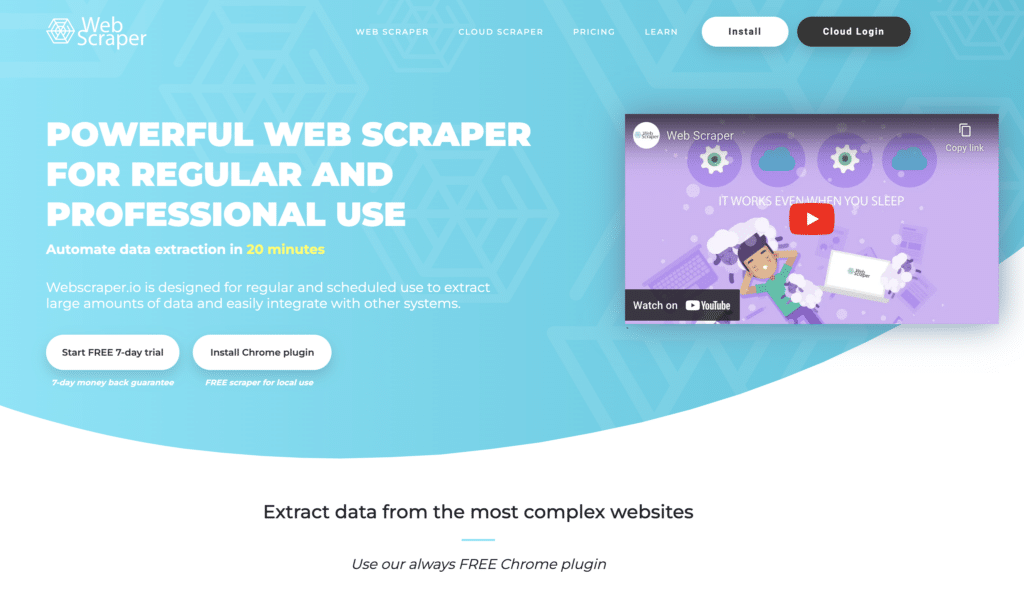

Ces données sont idéales pour des logiciels comme Webscraper qui vous simplifient la tâche en automatisant l’extraction des informations.

2. Les données non structurées

C’est un peu le bazar ici ! Ces données ne sont pas bien organisées, mais elles regorgent d’infos intéressantes :

- Texte : Blogs, descriptions de produits, forums… Ces contenus sont parfaits pour analyser des mots-clés, repérer des thèmes récurrents ou comprendre l’opinion des utilisateurs sur un sujet précis. ✍️

- Images : Idéal pour des études sur les tendances visuelles, comme la mode, le design, ou même la reconnaissance de produits. Avec les bonnes données, vous pouvez repérer des styles populaires ou suivre l’évolution d’un secteur. 📸

- Métadonnées : Infos cachées sur les pages web, comme les balises SEO, les descriptions, les url ou les informations techniques, qui sont essentielles pour optimiser votre stratégie en ligne ou auditer un site. 🔍

Ces données demandent parfois un peu plus de traitements, mais elles offrent plus d’informations une fois exploitées. 💡

3. Emails et contacts professionnels LinkedIn

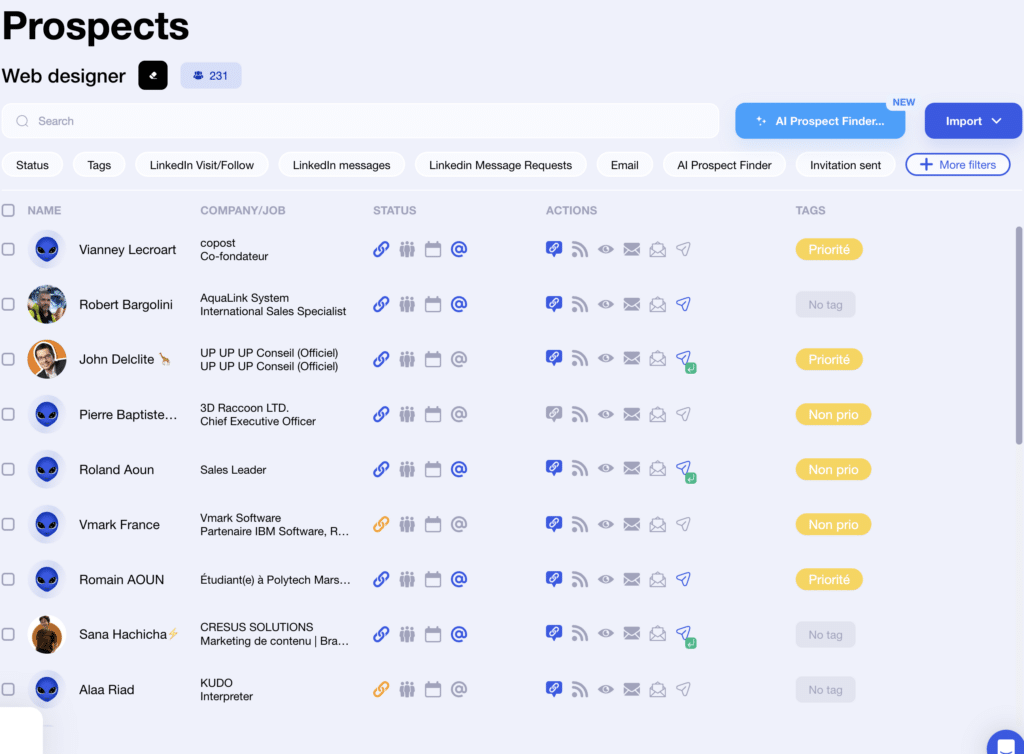

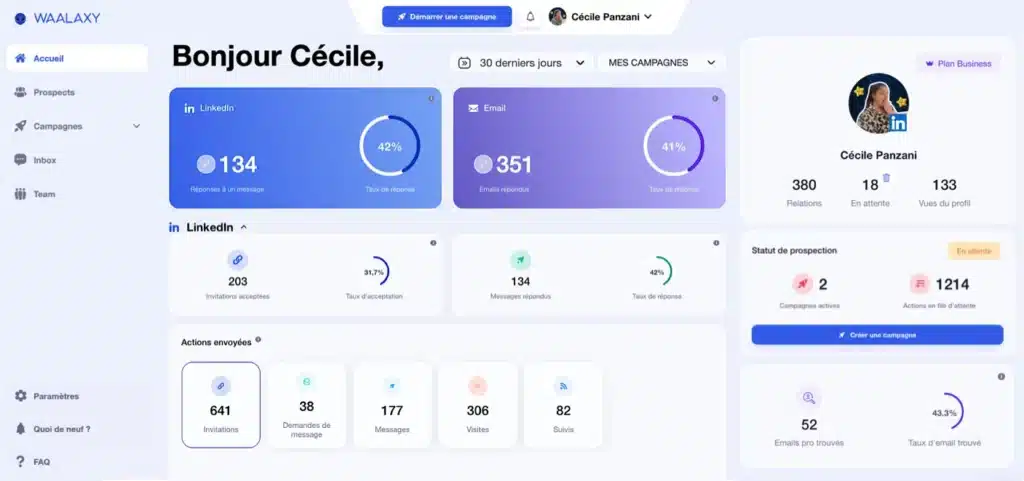

Besoin d’élargir votre réseau ou de prospecter efficacement ? Waalaxy c’est l’extension de navigateur qu’il vous faut pour exploiter tout le potentiel de LinkedIn ! 🚀

➡️ Ce que vous pouvez faire avec Waalaxy :

- Scraper des informations publiques sur LinkedIn : noms, postes, entreprises, et même les emails des profils grâce à l’Email Finder. 📊

- Récupérer des emails sécurisés : Grâce à son intégration avec Dropcontact, les emails collectés sont enrichis et validés dans le respect du RGPD. ✅

- Gérer vos données facilement : Waalaxy organise toutes les informations collectées pour un suivi clair. 🗂️

- Automatiser vos campagnes : Envoyez des messages personnalisés via LinkedIn ou par email sans effort manuel. 📧

- Connecter à votre CRM : Intégrez vos prospects directement dans votre CRM préféré pour une gestion centralisée. 🔗

- Suivre vos performances : Analysez vos campagnes de prospection pour les optimiser et maximiser vos résultats. 📈

4. Données des réseaux sociaux

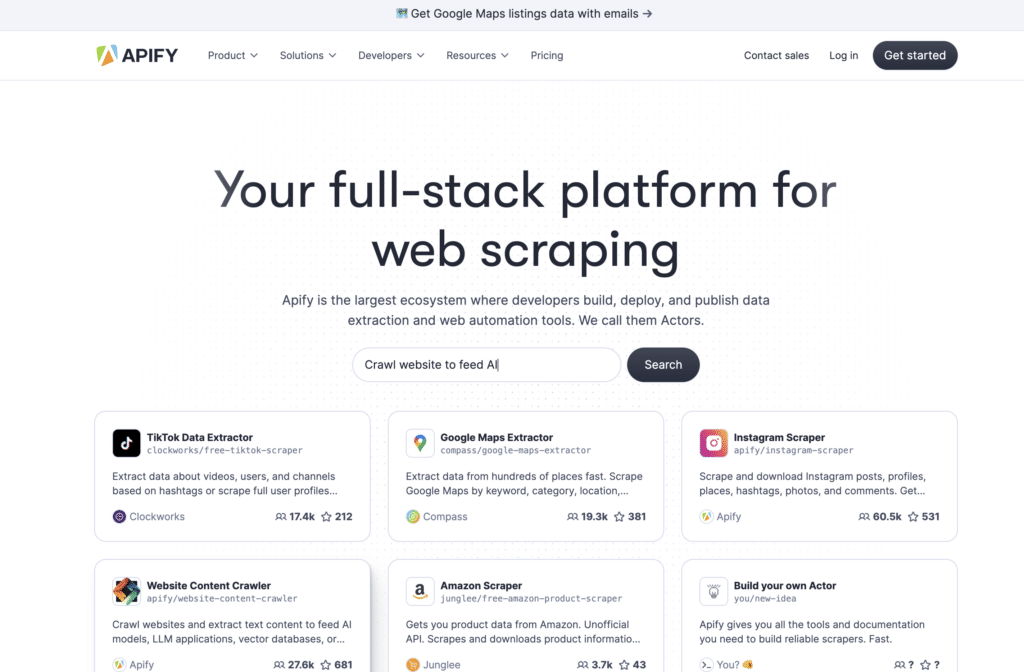

Les réseaux sociaux, c’est un vrai trésor d’infos ! 🌟 Ils regorgent de données publiques sur les entreprises et les professionnels : noms, postes, localisations, ou même publications récentes. Et bonne nouvelle : vous pouvez tout scraper facilement avec des outils comme Waalaxy ( pour scraper des données LinkedIn) ou Apify (Facebook, Instagram, X… ). 🎉

➡️ Vous pouvez, par exemple, scraper :

- Les hashtags et mentions populaires 🔥 : Découvrez les sujets tendance dans votre domaine pour rester à la page ou adapter votre stratégie social media.

- Les interactions sur les publications 💬 : Analysez qui commente, partage ou like pour mieux comprendre votre audience cible.

➡️ Scraper les réseaux sociaux, ça vous aide à :

- 🎯 Cibler vos prospects : Trouvez rapidement les bonnes personnes à contacter.

- 🚀 Adapter vos offres : Identifiez les besoins du marché grâce aux signaux des entreprises ou utilisateurs.

- 🛠️ Personnaliser vos campagnes : Construisez des messages de prospection et des stratégies vraiment adaptés à votre cible.

On se fait un récap sur le web scraping et le data scraping

Et voilà, vous êtes maintenant prêt à explorer le monde du web scraping et du data scraping ! 🚀 Ces techniques peuvent vraiment changer la donne pour vous, que vous soyez un marketeur, un entrepreneur ou un professionnel de la donnée. Grâce à elles, vous pouvez collecter et analyser des infos plus rapidement et de manière beaucoup plus efficace. 🤓

➡️ Pour récapituler, voici les principaux avantages du web scraping :

- Veille concurrentielle : Restez toujours à l’affût de ce que font vos concurrents pour ajuster vos stratégies en temps réel. 🧐

- Analyse de marché : Collectez des données pour mieux comprendre votre audience et repérer les tendances et faire votre étude de marché. 📊

- Automatisation des tâches : Dites adieu aux tâches répétitives et libérez du temps pour des actions plus stratégiques. ⏳

- Solution économique : Des outils accessibles, même pour les petites entreprises, sans se ruiner. 💸

- Sécurité des données : Collectez des données en toute sécurité, tout en respectant la législation. 🔒

Bien sûr, gardez toujours en tête l’importance de respecter la loi et d’agir de manière éthique. ⚖️ Et pour commencer, vous pouvez tester des outils comme Waalaxy pour vous simplifier la tâche ! 🎯

Foire aux questions

Est-ce que le web scraping est légal ?

La légalité du web scraping dépend de plusieurs facteurs : les lois, le type de données collectées (comme les données personnelles …), et les règles fixées par les sites web eux-mêmes. ✨

➡️ En règle générale :

- Données publiques : Extraire des données publiques accessibles à tous, comme les prix ou les avis clients, est généralement autorisé, surtout si vous les utilisez à des fins non commerciales. 👍

- Données protégées : Si les données sont protégées par un mot de passe ou nécessitent une authentification (comme des comptes utilisateurs), leur scraping peut être considéré comme une violation de la vie privée ou une infraction selon certaines lois. 🚫

- Copyright et propriété intellectuelle : Copier des contenus (textes, images, vidéos) protégés par des droits d’auteur pour les republier sans permission, c’est illégal. 🚨

Comment savoir si on peut scraper un site web ?

Il y a plusieurs étapes à suivre pour déterminer si vous pouvez scraper un site web en toute légalité et efficacité :

- Lire les CGU du site : Les conditions générales d’utilisation de nombreux sites précisent si le scraping est autorisé ou interdit. Si les CGU mentionnent une interdiction, scraper ce site pourrait vous exposer à des sanctions. 📜

- Vérifier le fichier robots.txt : Les sites web utilisent parfois un fichier appelé robots.txt, accessible en tapant « nomdusite.com/robots.txt » dans la barre d’adresse. Ce fichier vous indique les parties du site accessibles ou interdites aux robots (comme ceux des moteurs de recherche ou des scrapers). Mais, attention, c’est une directive, pas une obligation légale. Le suivre est une bonne pratique, mais ce n’est pas une règle absolue. 🤖

- Observer les protections techniques : Certains sites mettent en place des barrières pour empêcher le scraping, comme :

- Des CAPTCHAs (ces fameux tests « Je ne suis pas un robot » 🤖).

- Des blocages d’IP si vous effectuez trop de requêtes rapidement. 🚫

- Des structures dynamiques (JavaScript, Ajax) qui rendent les données plus difficiles à extraire. 💻 Si un site a ces protections, c’est probablement qu’il ne souhaite pas être scrappé. 🚧

- Demander une autorisation : Si vous avez un doute ou avez besoin de données spécifiques, contactez le site pour demander une autorisation explicite. Certaines entreprises proposent même des API pour collecter les données légalement. 📧

Même si un site semble techniquement accessible, cela ne signifie pas que vous avez le droit d’en extraire les données. Il est toujours préférable de vérifier avant de commencer. ✔️

À présent, le web scraping et le data scraping n’ont plus de secrets pour vous !